Introducción a la Cumbre de Seguridad de la IA

Actualizado 31 octubre 2023

Introducción a la Cumbre de Seguridad de la IA

1. Cumbre de seguridad de la IA: introducción

Estamos en medio de una revolución tecnológica que alterará fundamentalmente la forma en que vivimos, trabajamos y nos relacionamos unos con otros. La era de la Inteligencia Artificial (IA) ha comenzado y promete transformar aún más casi todos los aspectos de nuestra economía y sociedad, trayendo consigo enormes oportunidades, pero también riesgos que podrían amenazar la estabilidad global y socavar nuestros valores.

Las oportunidades de transformación son amplias: avanzar en el descubrimiento de fármacos, hacer que el transporte sea más seguro y limpio, mejorar los servicios públicos, acelerar y mejorar el diagnóstico y tratamiento de enfermedades como el cáncer y mucho más. Sin embargo, para aprovechar estas oportunidades, debemos asumir los riesgos, no solo como país sino como un esfuerzo global, razón por la cual estamos organizando la primera Cumbre Global sobre Seguridad de la IA.

La Cumbre de Seguridad de la IA se centrará en cómo gestionar mejor los riesgos de los avances más recientes en IA (“IA de frontera”, ver más abajo). Estos riesgos requieren una conversación internacional urgente dado el rápido ritmo al que se está desarrollando esta tecnología. La naturaleza dinámica de la IA significa que puede ser difícil predecir sus riesgos. Diferentes variables (cómo está diseñada la IA, los usos que se le da, los datos con los que se alimenta) pueden interactuar de maneras que son casi imposibles de predecir. Los gobiernos, académicos, empresas y grupos de la sociedad civil deben trabajar juntos para comprender estos riesgos y sus posibles soluciones.

En el camino hacia la Cumbre, existirán varias oportunidades para que las personas contribuyan a un debate inclusivo. La Cumbre en sí reunirá a un pequeño número de países, sector académico, representantes de la sociedad civil y empresas que ya han reflexionado en esta área para iniciar una conversación global crítica. Este es el tema central de la primera Cumbre de Seguridad de la IA organizada por el Reino Unido en Bletchley Park y un diálogo que continuaremos a partir de este evento.

2. Alcance de la Cumbre de Seguridad de la IA: ¿qué es Frontier AI?

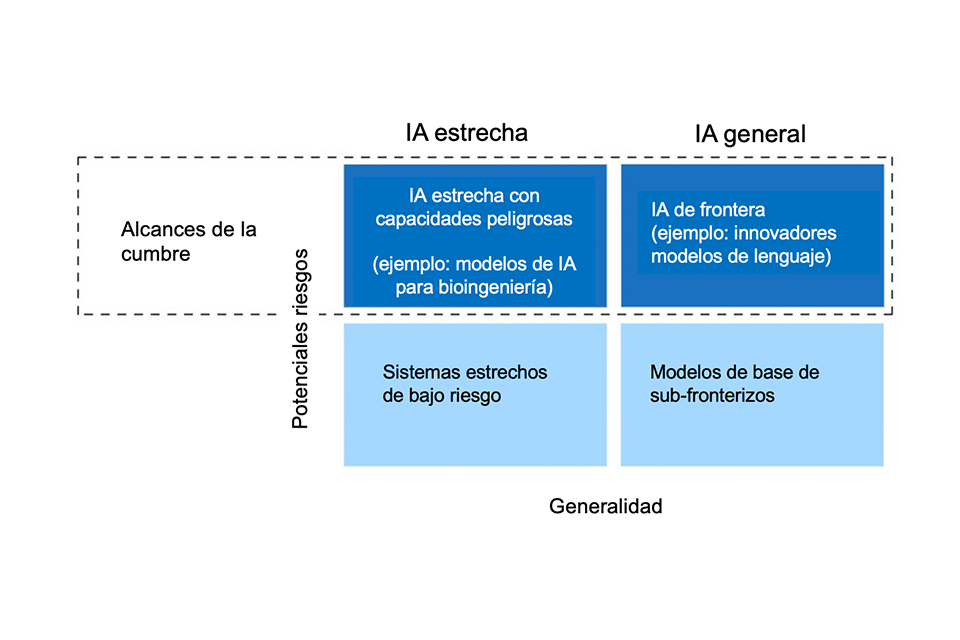

La Cumbre se centrará en ciertos tipos de sistemas de IA, en función de los riesgos que puedan plantear. Como se establece a continuación, estos riesgos podrían surgir de las capacidades más potencialmente peligrosas de la IA, que entendemos que se encuentran tanto en la “frontera” de la IA de propósito general como, en algunos casos, de la IA específica y limitada que puede contener capacidades potencialmente peligrosas.

Entendemos que la IA de frontera son modelos de IA de uso general, altamente capaces y que pueden realizar una amplia variedad de tareas e igualar o superar las capacidades presentes en los modelos más avanzados de la actualidad. Estos se basan en una serie de definiciones existentes utilizadas por diversos actores corporativos y de la sociedad civil.

Además de discutir nuestra comprensión de este tema con los asistentes a la Cumbre, el Reino Unido está avanzando en el trabajo para identificar específicamente dónde se encuentra actualmente la frontera del desarrollo de la IA y hacia dónde puede avanzar en el futuro.

Las tecnologías de IA están evolucionando a una velocidad sin precedentes. Pronto, es posible que se lancen modelos mucho más potentes que los disponibles actualmente. Las capacidades de estos modelos son muy difíciles de predecir (a veces incluso para quienes los construyen) y, por defecto, podrían ponerse a disposición de una amplia gama de actores, incluidos aquellos que podrían desearnos hacernos daño. Este ritmo de cambio significa que se necesitan medidas urgentes en materia de seguridad de la IA. Estamos en una encrucijada en la historia de la humanidad y girar en otra dirección sería una enorme oportunidad perdida para la humanidad.

Si bien la Cumbre se centrará en la IA de vanguardia, también será importante considerarlos junto con los riesgos de esta tecnología en ciertos casos de uso, es decir, a veces, como sistemas de IA limitados. Esto se debe a que no podemos predecir completamente el desarrollo de la tecnología y no podemos saber con certeza cuán limitados o generales serán los sistemas de IA más riesgosos del futuro, o en qué medida se pueden crear riesgos mediante el uso de IA limitada como herramientas para la IA general.

Alcance de la Cumbre de Inteligencia Artificial

Actualmente, la seguridad de la IA no tiene una definición universalmente aceptada, y es mejor considerarla como la prevención y mitigación de los daños causados por la IA. Estos daños podrían ser deliberados o accidentales; dirigidos a individuos, grupos, organizaciones, naciones o globalmente; y de muchos tipos, incluidos, entre otros, daños físicos, psicológicos o económicos.

2.1 Enfoque y objetivos

Como se ilustra en el diagrama anterior, hay un pequeño conjunto de daños potenciales que es más probable que se produzcan en la frontera o, en un pequeño número de casos, a través de sistemas restringidos muy específicos. Hay dos categorías particulares de riesgo en las que nos centramos:

1. Riesgos por uso indebido, por ejemplo, cuando un mal actor recibe ayuda de nuevas capacidades de IA en ataques biológicos o cibernéticos, desarrollo de tecnologías peligrosas o interferencia crítica en sistemas. Si no se controla, esto podría causar daños importantes, incluida la pérdida de vidas.

2. Riesgos por pérdida de control que podrían surgir de sistemas avanzados, que buscaríamos estuvieran alineados con nuestros valores e intenciones.

La Cumbre, al analizar específicamente la seguridad de la IA en la frontera, se centrará particularmente en estas dos áreas. Esto obedece a la necesidad urgente de una conversación internacional sobre cómo podemos trabajar juntos para enfrentar los nuevos desafíos que plantean estos riesgos, combatir el uso indebido de modelos por parte de actores no estatales y promover las mejores prácticas. Este enfoque se basa en el trabajo que aborda otros riesgos y daños de la IA, incluso en la OCDE, la Asociación Global sobre IA y el Consejo de Europa, y el Proceso de Hiroshima sobre IA.

Lo anterior no pretende minimizar los riesgos sociales más amplios que dicha IA (tanto en la frontera como fuera de ella) puede tener, incluida la desinformación, el sesgo, la discriminación y el potencial de automatización masiva. El Reino Unido considera que la mejor manera de abordar estos problemas es mediante los procesos internacionales existentes que están en marcha, así como los respectivos procesos internos de las naciones. Por ejemplo, en el Reino Unido estos riesgos se están considerando a través del trabajo anunciado en el white paper sobre la regulación de la IA y a través de un trabajo más amplio en todo el gobierno. Por lo tanto, es importante que el enfoque de la Cumbre sea complementario y no duplicativo de estos esfuerzos existentes, y que el Reino Unido y otras naciones continúen trabajando a buen ritmo en todos estos foros para abordar toda la gama de riesgos.

Por lo tanto, acogemos con satisfacción el trabajo realizado por nuestros socios internacionales para identificar medidas voluntarias apropiadas que puedan implementarse en ritmo y de forma provisional, mientras nuestra comprensión de la tecnología continúa evolucionando.

La primera Cumbre de Seguridad de la IA tiene cinco objetivos:

-

una comprensión compartida de los riesgos que plantea la IA de frontera y la necesidad de actuar

-

un proceso de avance para la colaboración internacional en materia de seguridad de la IA en la frontera, incluida la mejor manera de apoyar los marcos nacionales e internacionales

-

medidas apropiadas que las organizaciones individuales deberían tomar para aumentar la seguridad de la IA en la frontera

-

áreas de posible colaboración en la investigación de la seguridad de la IA, incluida la evaluación de las capacidades del modelo y el desarrollo de nuevos estándares para respaldar la gobernanza

-

demostrar cómo garantizar el desarrollo seguro de la IA permitirá que la IA se utilice para el bien a nivel mundial

3. Camino hacia la Cumbre – Compromiso

La Cumbre es solo el comienzo de un proceso global para identificar, evaluar y, en última instancia, mitigar los riesgos de la IA de vanguardia para que todas las personas podamos disfrutar de los beneficios públicos que la IA puede aportar.

Michelle Donelan, Secretaria de Estado de Ciencia, Innovación y Tecnología del gobierno británico, anunció el inicio del compromiso formal antes de la Cumbre a principios de septiembre con Jonathan Black y Matt Clifford, Representantes del Primer Ministro para la Cumbre de Seguridad de la IA, iniciando conversaciones con los países y un número de organizaciones líderes en IA de vanguardia. La Secretaria de Estado también organizó una mesa redonda con una muestra representativa de grupos de la sociedad civil y continúa manteniendo compromisos bilaterales para informar el compromiso y el programa de la Cumbre.

En las próximas semanas, el Gobierno seguirá colaborando con la comunidad científica nacional e internacional, la sociedad civil y las empresas para escucharles sobre el contenido de la Cumbre y sobre cuestiones más amplias relacionadas con la IA.

3.1 Ampliando la conversación

Para asegurar que la Cumbre pueda alcanzar los objetivos establecidos, es necesario garantizar un debate pequeño y centrado durante el evento de dos días, limitado a 100 participantes. Sin embargo, apreciamos la opinión de muchas más personas y organizaciones que tienen la experiencia y el deseo de contribuir a este tema crítico. El alcance de la Cumbre se centra en los riesgos de seguridad de la IA de vanguardia, pero nuestro compromiso más amplio garantizará que también se discutan otras cuestiones importantes.

Para permitir que se escuche una gama más amplia de voces, nos estamos asociando en cuatro eventos preliminares oficiales con la Royal Society, British Academy, techUK y The Alan Turing Institute. Los resultados de estos talleres se incorporarán directamente a la planificación de la Cumbre y publicaremos un resumen externo del compromiso.

| Fecha | Ponente | Objetivo |

|---|---|---|

| 11 octubre | The Alan Turing Institute | Analizar las fortalezas existentes del Reino Unido en materia de seguridad de la IA y las oportunidades de colaboración internacional. |

| 12 octubre | British Academy | Discutir las posibilidades de la IA para el bien público: la Cumbre y más allá. |

| 17 octubre | techUK | Analizar las oportunidades de la IA; Riesgos potenciales de la IA; Soluciones que existen en el sector tecnológico. |

| 25 octubre | Royal Society | Explorar los riesgos de seguridad de la IA en todas las disciplinas científicas. |

4. Compromiso público

La seguridad de la AI de frontera es un tema que nos afecta a todas las personas y no es simplemente una cuestión de personas expertas en academia y técnica. En el mes previo a la Cumbre, público de cualquier parte del mundo podrá hacer preguntas y compartir sus puntos de vista directamente con el gobierno británico.

Los detalles del evento se compartirán con anticipación en los canales de redes sociales del Departamento de Ciencia, Innovación y Tecnología (DSIT), con la posibilidad de verlo y publicar preguntas y comentarios en los canales de redes sociales en otros momentos.

| Fecha | Evento |

|---|---|

| 2 octubre | X Q&A con Matt Clifford, representante del Primer Ministro para la Cumbre de Seguridad de la IA |

| 16 octubre |

Q&A en LinkedIn con la Secretaria de Estado Michelle Donelan |

| 1 noviembre | Discursos de apertura en la transmisión en vivo de la Cumbre |

Revisa el programa completo de la Cumbre de Seguridad de IA en esta página en inglés.

A través de @scitechgovuk en X, LinkedIn, Facebook, Instagram y Threads se compartirán más actualizaciones sobre la Cumbre y oportunidades para participar en el período previo a la Cumbre y durante toda ella:

*Las redes sociales mencionadas publican en inglés.

5. Glosario

| Término | Definición |

|---|---|

| IA, sistemas de IA o tecnologías de IA | Productos y servicios que son “adaptables” y “autónomos”, en el sentido que se define en la sección 3.2.1 del documento en inglés AI White Paper. |

| Modelos Básicosl | Los modelos básicos son modelos entrenados con datos amplios a escala, de modo que puedan adaptarse a una amplia gama de tareas posteriores. - documento en inglés Stanford Centre for Research on Foundation Models. |

| IA de frontera | La IA de frontera está a la vanguardia del avance tecnológico y, por lo tanto, ofrece la mayor cantidad de oportunidades, pero también presenta nuevos riesgos. Se refiere a modelos de IA de uso general altamente capaces, generalmente modelos básicos, que pueden realizar una amplia variedad de tareas e igualar o superar las capacidades presentes en los modelos más avanzados de la actualidad. Posteriormente, puede habilitar casos de uso limitados. |

| IA estrecha | La inteligencia artificial estrecha (IA estrecha) es una IA diseñada para realizar una tarea específica. Es un tipo específico de inteligencia artificial en el que un algoritmo de aprendizaje está diseñado para realizar una sola tarea o un conjunto reducido de tareas, y cualquier conocimiento adquirido al realizar la tarea no será automáticamente aplicable ni transferible a una amplia variedad de tareas. |

| Automatización masiva | La automatización masiva es el proceso que lleva al software a completar tareas de una manera más rápida, eficiente y económica que la que pueden realizar los humanos. |